<TALM> 论文粗读

💡 Meta Data

| Title | TALM: Tool Augmented Language Models | | —————————————————————— | ————————————————————————————————————————————————– | | Journal | (10.48550/ARXIV.2205.12255) | | Authors | Parisi Aaron,Zhao Yao,Fiedel Noah | | Pub.date | 2022 |

📜 研究背景 & 基础 & 目的 (Motivation)

- LLM 需要工具:LLM 不能使模型解决需要访问训练时不可用短暂、变化或私人数据的任务,许多任务用API更好解决

- 最近研究将LLM连接到一个环境(仅是作为query的接受者)

🔬 研究方法

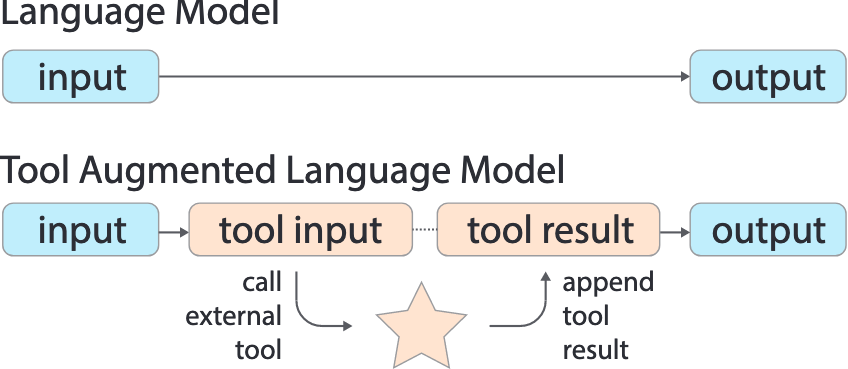

提出了工具增强语言模型(TALM),使用模型生成的输出调用任意工具,并关注工具输出以生成任务输出

贡献:

- 仅使用text-to-text 的API 来增强语言模型

- 提出自我博弈(self-play)技术,提高了在few-shot的启动性能

TALM模型

-

TALM 首先生成一个基于任务输入文本的工具输入,并通过生成分隔符,例如“ result”,调用工具的 API。 -

每当检测到这个分隔符时,就会调用工具 API,并将其结果附加到文本序列中。

- 然后,TALM 继续生成最终的任务输出。

TALM 同时学习两个子任务:调用工具和基于工具结果生成答案。

TALM 在架构上用了Seq2Seq模型

迭代Iterative self-play

- 首先有示例数据集,然后微调这个数据集,再在新数据集(无工具示例)生成工具调用的过程。

- 然后看最终结果怎么样,如果大于阈值就添加到原本的数据集中

这个过程虽然本文是单步的(使用单个工具的),但是很容易建模成多步的,用类似马尔科夫链建模

🚩 结论

- 一个知识密集型问答任务(NQ)和一个使用简单工具的推理导向数学任务(MathQA)上表现出色。

- TALM 成功地在问答和数学任务上进行分布外推理,而未增强的语言模型则失败。

- 小模型从工具中收益更多(知识密集的任务)

📌 感想 & 疑问

- 需要再搞清楚seq2seq模型和decoder-only模型的本质区别是什么 [created:: 2024-12-17] [due:: 2024-12-17]

- 这些论文学习工具的过程感觉都是 少样本->自己增强(标准不一样)->然后再微调自己